電子工学と神経科学の進歩により、研究者は視覚障害者の視界を取り戻すなど、脳インプラント装置で驚くべきことを達成することができました。 科学者は、物理的な感覚を回復することに加えて、話す能力を失った人々のためにコミュニケーションを促進する革新的な方法も模索しています。 たとえば、頭蓋骨の内側に埋め込まれた電極からデータを受信する新しい「デコーダ」は、麻痺した患者が自分の心だけを使って話すのに役立つかもしれません。

カリフォルニア大学サンフランシスコ校(UCSF)の研究者は、脳信号をコンピューター合成音声に変換する2段階の方法を開発しました。 科学誌Natureで今週発表された彼らの結果は、話す能力を失った人々のためにより流動的なコミュニケーションへの可能な道を提供します。

科学者は何年もの間、神経入力を利用して、脳卒中生存者やALS患者のように、神経学的損傷により会話が妨げられている人々に声を返すことを試みてきました。 これまで、これらのブレインコンピューターインターフェイスの多くは、文字ごとのアプローチを採用しており、患者は自分の目や顔の筋肉を動かして考えを綴ります。 (スティーブン・ホーキングは、彼の頬の小さな動きを通してスピーチシンセサイザーを監督したことで有名です。)

しかし、これらのタイプのインターフェースは緩慢で、最大で毎分10ワードを生成し、人間の毎分平均速度150ワードのほんの一部です。 より速く、より流動的なコミュニケーションのために、UCSFの研究者はディープラーニングアルゴリズムを使用して、神経信号を音声文に変換しました。

「これらの患者の脳は無傷ですが、ニューロン、つまり腕、口、または足に至る経路が破壊されています。 これらの人々は高い認知機能と能力を持っていますが、動き回ったり何かを言ったりするような日々のタスクを達成することはできません」 「私たちは本質的に、故障した経路をバイパスしています。」

研究者は、数年間にわたって5人のボランティアから収集した高解像度の脳活動データから始めました。 これらの参加者(全員が正常な発話機能を持っていた)は、脳に直接電極を埋め込むことを含むてんかん治療のモニタリングプロセスをすでに受けていました。 Changのチームは、これらの電極を使用して、患者が何百もの文章を読み上げたときに、脳の音声関連領域の活動を追跡しました。

そこから、UCSFチームは話し言葉を再現する2段階のプロセスを作成しました。 まず、デコーダーを作成して、記録された脳活動パターンを、仮想の声道の一部(唇、舌、顎、喉頭など)を動かすための指示として解釈します。 その後、仮想の動きを使用して言語を生成するシンセサイザーを開発しました。

他の研究では、動きのデコードの中間ステップをスキップして、神経信号から単語と音を直接デコードしようとしました。 ただし、昨年UCSFの研究者が発表した研究では、脳の音声センターは、結果として生じる音ではなく、声道を動かして音を出す方法に焦点を当てていることが示唆されています。

「音声センターの脳活動のパターンは、特に声道の動きを調整することに向けられており、音声自体に間接的にのみリンクされています」今週の記者会見で述べた。 「サウンドを直接デコードするのではなく、サウンドを作成するために動きを明示的にデコードしようとしています。」

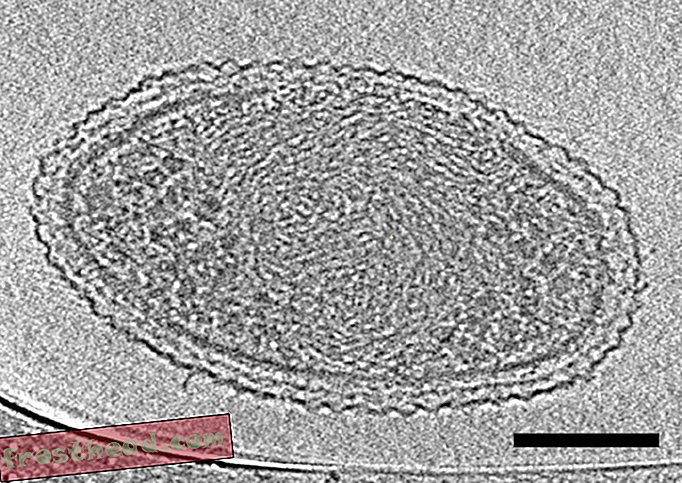

脳の活動を記録するために使用されるタイプの頭蓋内電極の例の脳インプラント配列。 (UCSF)

脳の活動を記録するために使用されるタイプの頭蓋内電極の例の脳インプラント配列。 (UCSF) この方法を使用して、研究者は、参加者の発話の音声記録にほぼ一致する脳活動から単語と文をリバースエンジニアリングすることに成功しました。 オンラインクラウドソーシングプラットフォームのボランティアに、ワードバンクを使用して単語を特定し、文章を書き込もうとすると、彼らの多くはシミュレートされた音声を理解できましたが、正確さは完全ではありませんでした。 101個の合成文のうち、約80%が25ワードバンクを使用して少なくとも1人のリスナーによって完全に書き起こされました(ワードバンクのサイズが2倍になると、その割合は約60%に低下しました)。

これらの結果が他の合成音声試験とどのように比較されるかを言うのは難しい、と新しい研究に関与しなかった北西部の神経学者であるMarc Slutzkyは電子メールで述べている。 Slutzkyは最近、同様の研究に取り組み、声道の動きをデコードすることなく、大脳皮質信号から直接合成語を生成しました。結果の音声品質は類似していると考えています。

しかし、UCSFの研究の興味深い側面の1つは、デコーダーが参加者全体の結果を一般化できることです、とSlutzky氏は言います。 このタイプの研究の主な課題は、デコーダアルゴリズムのトレーニングには通常、参加者が話すことを必要とすることですが、この技術はもはや話すことができない患者を対象としています。 アルゴリズムのトレーニングの一部を一般化できると、麻痺した患者のさらなる作業が可能になります。

この課題に対処するために、研究者は、声を出して話すのではなく、静かに文章を模倣した参加者でデバイスをテストしました。 結果の文章はそれほど正確ではありませんでしたが、著者は、発声された音声がなくても合成が可能であったという事実は刺激的な意味を持っていると述べています。

「音声をまったく生成しない行為から音声信号を生成できることを発見したことは本当に驚くべきことでした」と、UCSFの研究およびバイオエンジニアリングの大学院生の共同主執筆者であるJosh Chartierは記者会見で述べました。 。

現在の研究で脳の活動を記録するために使用されるタイプの頭蓋内電極のサンプルアレイを保持している研究著者Gopala Anumanchipalli博士の画像。 (UCSF)

現在の研究で脳の活動を記録するために使用されるタイプの頭蓋内電極のサンプルアレイを保持している研究著者Gopala Anumanchipalli博士の画像。 (UCSF) 将来の研究のもう1つの目標は、デコーダーのリアルタイムのデモを追求することです、とAnumanchipalliは言います。 現在の研究は概念実証としての意味があります。デコーダーはデータ収集プロセスとは別に開発され、チームは脳活動を合成音声に変換するリアルタイムの速度をテストしませんでしたが、これは最終的な目標です臨床機器。

そのリアルタイム合成は、将来そのようなデバイスが有用であるためには改善が必要なものである、と研究に関与しなかったスタンフォードの神経外科医であるジェイミー・ヘンダーソンは言う。 それでも、著者の2段階の方法は刺激的な新しいアプローチであり、ディープラーニングテクノロジーを使用すると、音声が実際にどのように機能するかについての新しい洞察が得られると彼は言います。

「私にとって、人の中でどのようにスピーチが生成されるかという根本的な基礎を調査し始めるという考えは非常に刺激的です」とヘンダーソンは言います。 「[この研究]は、私たちの最も人間的な能力の1つを基本的なレベルで探索し始めます。」