何かをつかむと、あなたの手がほとんどの仕事をします。 あなたの脳は「行く、それがどうなるか心配しないで」と言うだけです。 しかし、最先端の人工装具でも、その行動にはより多くの意図が必要です。 その結果、多くの患者は最先端の手足を放棄しています。

関連性のあるコンテンツ

- ニューラルネットワークをハッキングすると、切断者が卵を完璧に割るのにどのように役立つか

- 補綴物を手に入れるのは、やりたいことをするのに比べて簡単です

現代の人工装具は、装着されている筋肉から電気信号の形でコマンドを受け取ります。 しかし、最高の補綴物でさえまだ多くのことはできません。 手足に慣れるには、長いトレーニング期間が必要です。 多くの場合、移動できるのは限られた方法であり、ユーザーはグリップを手動で切り替えてさまざまなタスクを実行する必要があります。たとえば、ドアを開くかピンチしてキーを回すかです。 全体として、それは手が脳とシームレスに動作できないことを意味します。

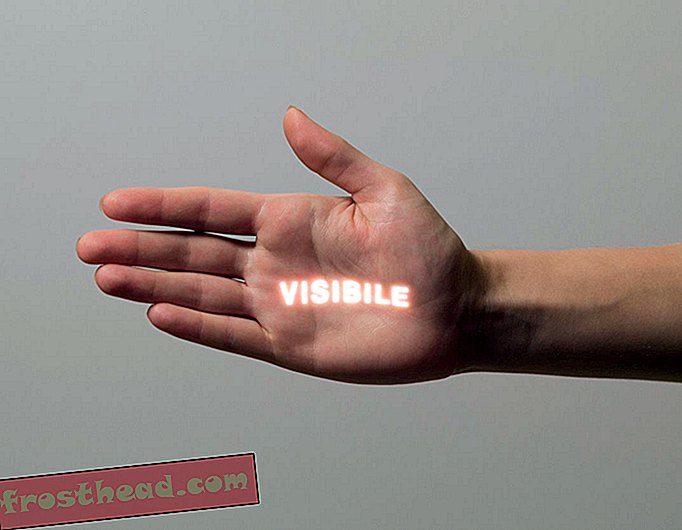

この問題の解決に役立つツールの1つにコンピュータービジョンがあります。 ニューカッスル大学の研究者は、人工の手にウェブカメラを取り付け、それをディープラーニングニューラルネットワークに接続し、腕を手首から肘まで切断した2人の切断者にデバイスを渡しました。 コンピューターはカメラを使用して、ユーザーが何を求めているのかを確認し、義足のグリップを自動的に調整しました。

これまでのところ、結果は有望です。 Journal of Neural Engineeringの記事で、ニューカッスルのチームは、ユーザーがオブジェクトを拾い上げて移動する成功率が80%を超えていると報告しました。

ニューカッスルの博士課程の学生であり、論文の筆頭著者であるガザル・ガザエイは、「それを改善できれば、100パーセントを得ることができれば、切断者に手を使う方がはるかに信頼できるでしょう。」実生活で使用され、エラーがないはずです。」

デバイス自体はi-limb ultraと呼ばれる市販の人工装具であり、Webカメラは低解像度で安価なLogitech Quickcam Chatでした。 真の革新は、Ghazaeiのチームがウェブカメラからの情報を使用するためのコンピューター学習スキームを考案した方法でした。

ソフトウェアは、持ち上げるオブジェクトの形状のパターンを認識し、効果的に把握するために必要なグリップに基づいて、それらをカテゴリに分類します。 この手法をコンピューターに教えるために、Ghazaeiは500個のオブジェクトを5度ずつ撮影した72枚の画像を提供しました。 ソフトウェアはオブジェクトを機能ごとにフィルタリングし、試行錯誤を通じてどのオブジェクトがどのカテゴリに分類されるかを学習します。

次に、補綴物にオブジェクトが提示されると、ネットワークはその幅広で抽象的な形状に基づいて低解像度画像を分類します。 システムが以前に見たものである必要はありません。オブジェクトの一般的な形状は、使用するグリップを手に伝えるのに十分です。 Ghazaeiとチームは、ピンチ(2本の指)、三脚(3本の指先)、ニュートラルパルマー(コーヒーカップを握るような)、および回内パルマー(手のひらが下向き)を含む4つのグリップタイプを使用しました。

コンピュータービジョンは、以前は、義手と産業用ロボットの両方でロボットの手に使用されてきました。 しかし、そのような努力は、製造環境のような標準サイズと形状のオブジェクト、またはより遅いアルゴリズムのいずれかを含んでいます。 ニューカッスルで開発されたシステムは、450マイクロ秒、つまり約1/2000秒でオブジェクトを正しく分類するのに十分な速度でこのプロセスを実行できました。 「主な違いは、タスクを把握して実行するのにかかる時間です」とGhazaei氏は言います。 「そのうちのいくつかは約4秒で、いくつかはスナップショットが必要です。 私たちにとって、それはただのスナップショットであり、非常に高速です。」

この技術の影響は、家庭用品を拾うことをはるかに超えています。 イメージングシステムは、義足の地面からの距離を把握し、それに応じて調整するのに役立ちます。 両方のインスタンスに共通するのは、脳と連携して動作するロボットシステムです。

「主なアイデアは、ロボットデバイスと人間との相互作用を実現し、ロボットシステムにインテリジェンスを追加することです」と、ロンドン大学インペリアルカレッジの神経リハビリテーションエンジニアリングの教授であるダリオファリーナは言います。接続するデバイス。

「彼の脳と神経インターフェースを介して補綴物を制御するのは患者だけでなく、補綴物に取り付けられ環境を見ることができる第2の知的実体によって患者が助けられます」ニューカッスル研究に関与していなかったファーニアは言います。「これにおける主な課題は、人間と知性システムの間でコントロールを共有できるようにすることです。」

それは、人工知能と脳の融合への初期の侵入であり、対立を生じさせることなく、それぞれに最適なアクションを選択します。 ガザエイはこの問題に直面しています。 彼女は、ユーザーのアクションに対して、義肢のコンピューターによってどの程度の広い動きが制御されるかを管理するためにまだ働いています。 今、ユーザーは補綴物をアイテムに向け、写真を撮るように誘導し、次に腕がつかみを握って掴みます。

これは、残っている多くの課題の1つにすぎません。 現時点では、システムは視界外に広がる長いオブジェクトを理解できません。 混雑した背景には問題があります。 時には、遠くのオブジェクトをより小さく、より近いオブジェクトとして解釈します。 また、Ghazaeiは、把握タイプの数を10または12に増やすことも別の目標であると言います。 しかし、試験の2人のユーザーは、パフォーマンスの向上と、何かを拾うという基本的な行為に役立つシンプルさをすでに評価していた、と彼女は言います。