記念日は毎年私たちに思い出させるように、戦争はなくなりません。

しかし、それは変わります。 そして、今後数年間で見られるより深刻な変化の1つは、ロボットにますます依存する軍隊への移行です。 現在、ドローンが注目を集めていますが、国防総省のイノベーションの多くは、実験用航空機から地上の兵士まで、他の種類の無人機です。

魅力を理解するのは簡単です。 ロボットを使用する方が、戦争で人間だけに頼るよりも潜在的に効率的で、正確で、安価です。 そしてもちろん、それは人間の犠牲者が減ることを意味します。

しかし、この変革には複雑な課題が伴います。軍用機械をプログラムして決定を下すことはできますか? ロボットは道徳を学ぶことができますか?

米国海軍研究局は、今がそれを発見する時だと考えています。 今月初めに、タフツ、ブラウン、イェール、ジョージタウンの各大学とレンセラー工科大学(RPI)で、ある機械がいつか間違っているかを選択できるかどうかに関する研究に資金を提供する5年間の750万ドルの助成金を発表しました。

海軍は、Googleの自動運転車が現在直面している状況を回避したいと考えています。それは、それが提起する法的および倫理的問題の明確さよりもはるかに先にリリースされた技術を持つことです。 自律型ロボットが現場に出る前に、軍隊は実際に正しいことを行うことができるかどうかを知りたいと思っています。

RPIの認知科学部長であるSelmer Bringsjordが見ているように、ロボットの人工知能は2つのレベルの道徳で機能するように設計できます。 1つ目は、「負傷した兵士に出くわした場合、あなたは彼または彼女を助けるべきである」などの明確な倫理的選択のチェックリストに基づくでしょう。しかし、この行動が、他の兵士? その時点で、ロボットは「より深い道徳的推論」に関与して、プログラマーが予期していなかった状況で意思決定を下す能力を持つ必要があるとブリングスジョードは言います。

研究者は、自律ロボットの既存のアーキテクチャに統合できる独自のアルゴリズムと計算メカニズムを開発する必要があります。これは、機械が道徳的推論を適用する能力に基づいて計画された動作をオーバーライドできる「思考プロセス」です。

これが非常に野心的であると思われる場合は、そうです。 まず、研究者は、人間の道徳の基本的な要素を分離する必要があります-どの原則について私たち全員が同意しますか?-次に、ロボットにある程度の道徳的能力を与えるアルゴリズムにそれらを組み込む方法を見つけます。

それは小さな仕事ではありません。 そのため、人間によって制御されないマシンは、近い将来、監視、セキュリティ、捜索救助、医療などの非戦闘的役割に限定される可能性があります。 しかし、必然的に、軍事計画者は、これらすべてに絡む質問への答えを求めます。ロボットは、自分で行動して、人間を殺すことを許可されるべきですか?

マシンの90%が、車両の全員がテロリストであると確信している場合、それは十分に確かですか? ロボットが敵であると判断した場合、ロボットは子供に武器を発射できますか? 何かがうまくいかず、自律ロボットが誤って村を爆破した場合、誰が責任を負いますか? 操作を命じた司令官? ロボットをプログラミングした人は? または誰も?

これがまだサイエンスフィクションだと思うなら、今月初め、人工知能から人権、国際法まで、幅広い分野の専門家がジュネーブで開催された国連会議で「キラーロボット」について議論したと考えてください。 ヒューマン・ライツ・ウォッチやパキスタン、エジプト、キューバ、バチカンなどの一握りの国の当局者などのグループは、殺す権限を持つロボットの全面的な禁止を求めました。 しかし、ほとんどの国、特に最先端のロボットを備えた国は、そこまで行く準備ができていません。

たとえば、WildCatを見てみましょう。WildCatは、あらゆる種類の地形で高速で動作するように開発されている4本足のロボットです。

現時点では、米軍は2012年国防総省の指令に従っており、殺す力を持つマシンは完全に自律することはできません。 人間は、文字通り、ショットを呼び出さなければなりません。 しかし、それはすべての場所に当てはまるわけではありません:3月、 ニューサイエンティストは、5人の弾道ミサイル設置のロボット歩riesが、人間が先に進まなくてもターゲットを検出して破壊できるとロシアの当局者を引用しました。

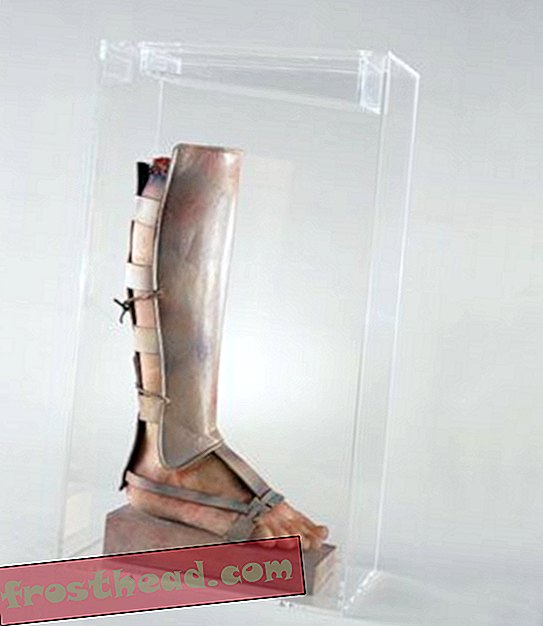

以下に見られるFoster-Miller Talonは、戦闘用に開発されている世界中の多くの機械の1つです。

戦争のルール

キラーロボット会議に関するレポートは、11月に国連の特定の兵器共同体委員会に提出されます。 しかし、すぐに禁止が来るようには見えません。

ジュネーブでの議論に参加したのは、ジョージア工科大学の人工知能の専門家であるロナルドアーキンでした。彼は、機械に道徳的な決定を下す能力を長年提唱してきました。 彼は、ロボットが国際法に従うことを学ぶことができれば、彼らは間違いなく一貫しているので、実際に戦争で人間よりも倫理的に振る舞うことができると信じています。 彼らは怒りやパニックや偏見で対応することはできません。 アーキンは禁止に反対しますが、機械に戦争のルールをマスターできるかどうかを確認する機会が与えられるまで、自律兵器の一時停止を受け入れています。

ジュネーブでアーキンを議論した別のAI科学者、ノエル・シャーキーは非常に異なる心です。 彼は、ロボットに生死を決定する権限を与えるべきではないと考えています。

最近、彼はDefense Oneにこう語った。「彼らが道徳的または倫理的なロボットになるとは思わない。 そのためには、道徳的な機関が必要です。 そのためには、他人を理解し、苦しむことの意味を知る必要があります。」

「ロボットにはいくつかの倫理規則がインストールされている場合がありますが、実際には気にしません」と彼は言います。